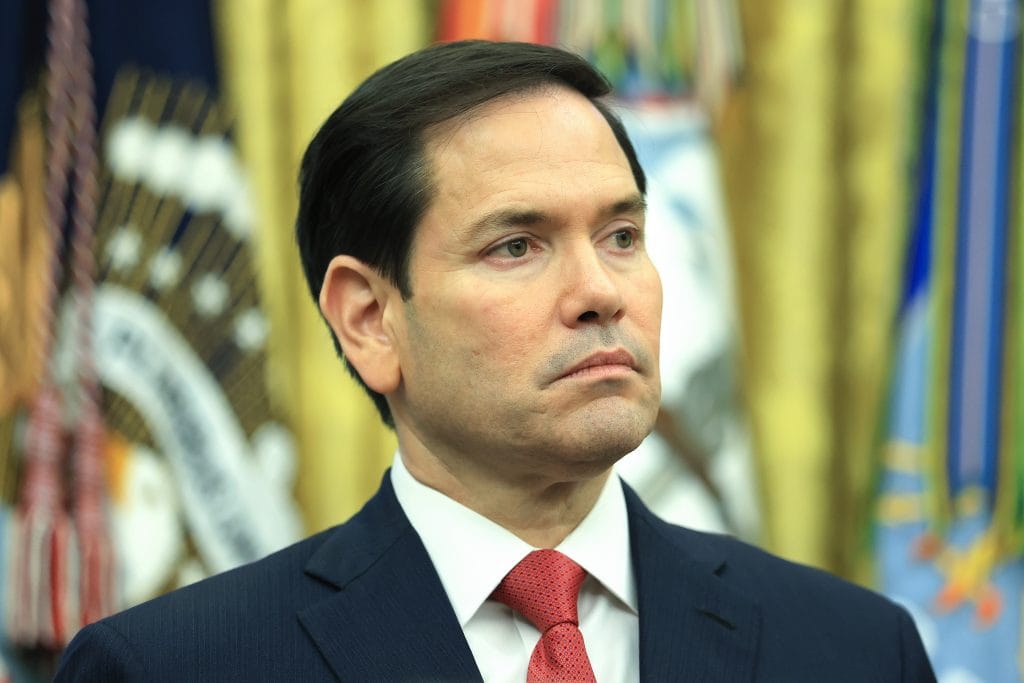

Os golpes com tecnologia de deepfake têm crescido silenciosamente, e o caso mais recente envolve uma tentativa de fraude com uma voz clonada digitalmente do secretário de Estado norte-americano Marco Rubio, que teria enviado mensagens de voz geradas por inteligência artificial (IA) a ministros estrangeiros, um governador dos EUA e um membro do Congresso. A informação consta em um memorando do Departamento de Estado datado de 3 de julho e foi confirmada por uma autoridade sênior do governo.

Até o momento, não há evidências públicas de que os destinatários das mensagens tenham sido enganados ou que tenham repassado informações confidenciais. Ainda assim, o episódio se soma à crescente lista de casos que mostram o quão fácil — e perigosamente convincente — se tornaram os golpes com vozes falsas geradas por IA.

Com apenas 15 a 30 segundos de uma gravação de voz, serviços como Eleven Labs, Speechify e Respeecher conseguem replicar digitalmente qualquer fala, permitindo que qualquer mensagem digitada seja reproduzida com a entonação da pessoa clonada. Embora essas ferramentas tenham usos legítimos, como acessibilidade e criação de conteúdo, elas também estão sendo exploradas por golpistas.

Deepfakes de áudio e vídeo não são novidade, especialmente envolvendo figuras públicas e executivos de alto escalão. Mas a gravidade da ameaça aumentou. O número de incidentes relacionados a deepfakes saltou de 150 em todo o ano de 2024 para 580 apenas no primeiro semestre de 2025, segundo estudo da Surfshark — quase quatro vezes mais. As perdas financeiras somam impressionantes US$ 897 milhões, sendo US$ 410 milhões só neste ano. O golpe mais comum: imitação de personalidades públicas para promover investimentos fraudulentos, o que já resultou em perdas de US$ 401 milhões.

“Os deepfakes evoluíram para ameaças reais e ativas à cibersegurança”, afirma Aviad Mizrachi, CTO e cofundador da empresa de segurança Frontegg. “Já vemos chamadas de vídeo geradas por IA enganando funcionários a ponto de autorizarem pagamentos milionários. Esses ataques estão ocorrendo agora, e o processo se tornou assustadoramente fácil para um hacker.”

Mizrachi alerta que os métodos tradicionais de autenticação — como senhas, códigos temporários e apps de verificação — não foram projetados para um cenário onde um golpista pode clonar sua voz ou rosto em segundos. O perigo está no fator humano: os golpes se baseiam em enganar alguém para entregar credenciais ou autorizar ações, não necessariamente em invadir sistemas.

“Essas medidas tradicionais para verificar identidades simplesmente já não funcionam mais”, diz ele. Segundo o especialista, a maioria das equipes de cibersegurança ainda ignora os deepfakes — e é justamente essa brecha que os criminosos exploram. Um áudio falso, mas convincente, pode levar uma pessoa a ignorar protocolos de segurança e autorizar transferências ou acessos.

Para combater esse tipo de fraude, Mizrachi recomenda o uso de dispositivos físicos para autenticação — como smartphones ou chaves de segurança — por meio de tecnologias como FIDO2 ou WebAuthn, que são muito mais difíceis de falsificar. Além disso, sistemas de verificação inteligentes podem analisar comportamentos, como velocidade de digitação, localização e padrões de login, ajudando a identificar tentativas de fraude que uma voz clonada não conseguiria imitar.

Para Margaret Cunningham, diretora de segurança e estratégia de IA da empresa Darktrace, a tentativa de imitar Rubio mostra como a IA generativa pode ser usada para criar ataques de engenharia social altamente direcionados e convincentes.

“Essa tentativa não falhou por falta de sofisticação, e sim por não ter encontrado a vítima no momento certo de vulnerabilidade”, explica. “As pessoas raramente tomam decisões com calma e foco total. Elas estão multitarefas, sob pressão e guiadas pelo que parece familiar. Nessas condições, uma voz confiável ou uma mensagem com aparência oficial pode facilmente contornar a cautela.”

Democracias sob ameaça global

A IA generativa também reduziu drasticamente o custo e a complexidade da manipulação de mídia, tornando o processo mais rápido, barato e escalável. Isso tem afetado democracias no mundo todo. Segundo reportagem recente do New York Times, deepfakes alimentados por IA já influenciaram eleições em pelo menos 50 países, sendo usados para descredibilizar ou difamar adversários políticos.

“Essa é a nova fronteira das operações de influência”, alerta Leah Siskind, pesquisadora em IA na Foundation for Defense of Democracies. “Já vimos casos de deepfakes envolvendo autoridades do alto escalão para acessar contas pessoais. Mas o uso de IA para influenciar relações diplomáticas e decisões políticas é uma escalada perigosa. É uma questão urgente de segurança nacional com implicações diplomáticas sérias.”

Como medida preventiva, Siskind recomenda que autoridades evitem o uso de aplicativos populares de mensagens criptografadas, como o Signal, que embora protejam o conteúdo, não oferecem verificação de identidade. “Dada a facilidade em criar áudios falsos e perfis convincentes em apps acessíveis ao público, autoridades devem usar apenas canais de comunicação altamente seguros”, alerta.